-

9 мая 2021 в 21:37 DDoS атаки на 7 уровень (на уровень приложения) наиболее простой способ привести в нерабочее состояние сайт и навредить бизнесу. В отличие от атак на другие уровни, когда для отказа сайта необходимо организовать мощный поток сетевого трафика, атаки на 7 уровень могут проходить без превышения обычного уровня сетевого трафика. Как это происходит, и как от этого можно защищаться я рассмотрю в этом сообщении.Читать дальше →

-

-

Выпуск nginx 1.19.1014 апреля 2021 в 14:04 Комментарии: 4

-

Forbes: F5 Networks просит суд оставить без рассмотрения иск Lynwood против Nginx30 августа 2020 в 18:50 Комментарии: 15

-

Вышла превью версия NGINX QUIC+HTTP/311 июня 2020 в 13:50 Комментарии: 6

-

Сбербанк планирует увеличить долю в Rambler Group9 июня 2020 в 00:43 Комментарии: 23

-

Генпрокуратура: уголовное дело против Nginx до сих пор не прекращено27 мая 2020 в 18:30 Комментарии: 119

-

-

30 апреля 2021 в 11:19 Есть ли корпоративная жизнь на удаленке и как ее обеспечить: интеграция внутренней системы аутентификации

Читать далее

Читать далееВ digital-агентстве Convergent, где я работаю, в потоке множество проектов, и у каждого из них может быть собственная админка. Есть несколько окружений (дев, стейдж, лайв). А ещё есть разные внутрикорпоративные сервисы (как собственной разработки, так и сторонние вроде Redmine или Mattermost), которыми ежедневно пользуются сотрудники.

Наша команда всегда была распределённой между несколькими офисами, но с учётом событий последнего года все сотрудники перешли на удалёнку. Так мы столкнулись с необходимостью организовать всё многообразие внутренних и клиентских сервисов в единой системе.

-

30 апреля 2021 в 01:50 Домашний медиа сервер minidlna

Читать далее

Читать далееТак сложились обстоятельства, что мне удалось скоммуниздить старенький ПК, да и чтобы он просто не пылился, так как такое старье продавать за 5-7 тысяч (цена в моем регионе за подобную конфигурацию) мне стыдно, а получать за него 3 тысячи — ну такое. Я решил, сделаю дома небольшую библиотеку фильмов, музыки, да и у жены очень много фотографий, которые её очень дороги.

-

21 апреля 2021 в 13:01

21 апреля 2021 в 13:01

Вышел релиз nginx 1.20.0

Читать дальше →

С момента выхода прошлой версии nginx прошел целый год. Сейчас представлена новая стабильная ветка nginx 1.20.0. По словам разработчиков, в нее вошли все изменения, которые ранее были накоплены в ветке 1.19.x. В новой ветке изменения будут связаны с ликвидацией серьезных ошибок и уязвимостей.

В ближайшее время разработчики сформируют основную ветку 1.21, которая будет получать новые возможности. Тем пользователям, кому не нужна совместимость со сторонними модулями, рекомендуется использовать основную ветку. На ее основе раз в квартал формируются выпуски коммерческого продукта Nginx Plus.

-

11 апреля 2021 в 19:17 Развертывание приложений Django

Читать далее

Читать далееПосле того, как мы закончили разработку веб-приложения, оно должно быть размещено на хосте, чтобы общественность могла получить доступ к нему из любого места. Мы посмотрим, как развернуть и разместить приложение на экземпляре AWS EC2, используя Nginx в качестве веб-сервера и Gunicorn в качестве WSGI.

-

8 апреля 2021 в 11:02

8 апреля 2021 в 11:02

Липкие сессии для самых маленьких [Часть 1]

- Tutorial

Вляпаться

ВляпатьсяЛипкие сессии (Sticky-session) — это особый вид балансировки нагрузки, при которой трафик поступает на один определенный сервер группы. Как правило, перед группой серверов находится балансировщик нагрузки (Nginx, HAProxy), который и устанавливает правила распределения трафика на доступные сервера.

В первой части цикла мы посмотрим как создавать липкие сессии с помощью Nginx. Во второй же части разберем создание подобной балансировки средствами Kubernetes.

-

27 марта 2021 в 17:06

27 марта 2021 в 17:06

Развертывание ML модели в Docker с использованием Flask (REST API) + масштабирование нагрузки через Nginx балансер

- Tutorial

Читать дальше →Как известно настройка и обучение моделей машинного обучения это только одна из частей цикла разработки, не менее важной частью является развертывание модели для её дальнейшего использования. В этой статье я расскажу о том, как модель машинного обучения может быть развернута в виде Docker микросервиса, а также о том, как можно распараллелить работу микросервиса с помощью распределения нагрузки в несколько потоков через Load balancer. В последнее время Docker набрал большую популярность, однако здесь будет описан только один из видов стратегий развертывания моделей, и в каждом конкретном случае выбор лучшего варианта остаётся за разработчиком.

-

23 марта 2021 в 10:30

23 марта 2021 в 10:30

Продолжение. Частые ошибки в настройках Nginx, из-за которых веб-сервер становится уязвимым

- Блог компании Cloud4Y,

- Информационная безопасность,

- Системное администрирование,

- IT-инфраструктура,

- Nginx

- Перевод

Читать далее

Читать далееРанее Cloud4Y рассказал про уязвимости веб-серверов Nginx, балансировщиков нагрузки и прокси-серверов. Что-то из этого вы могли знать, а что-то, надеемся, стало полезной информацией.

Но история не закончилась. Многочисленные программы bug bounties позволяют проводить широкомасштабные исследования, благодаря которым удаётся найти реально действующие уязвимости. Проект Gixy помог найти множество неправильных конфигураций промежуточного ПО, но далеко не все. Что ещё удалось обнаружить:

-

21 марта 2021 в 10:00

21 марта 2021 в 10:00

Домашний DPI, или как бороться с провайдером его же методами

...При помощи NGINX!

...При помощи NGINX!Долгое время я терпел ограничения РосКомНадзора и соответствующие действия провайдеров по различным ограничениям доступа к сайтам - но с определённого момента устал, и начал думать как бы сделать так, чтобы было и удобно, и быстро, и при этом с минимумом заморочек после настройки... Хочу оговориться, что цель анонимизации не ставилась.

Вообще, эта проблема имеет несколько решений... Но я решил бороться с провайдером их же методом.

-

16 марта 2021 в 10:08

16 марта 2021 в 10:08

Частые ошибки в настройках Nginx, из-за которых веб-сервер становится уязвимым

- Блог компании Cloud4Y,

- Информационная безопасность,

- Системное администрирование,

- IT-инфраструктура,

- Nginx

- Перевод

Читать далее

Читать далееNginx — это веб-сервер, на котором работает треть всех сайтов в мире. Но если забыть или проигнорировать некоторые ошибки в настройках, можно стать отличной мишенью для злоумышленников. Detectify Crowdsource подготовил список наиболее часто встречающихся ошибок, делающих сайт уязвимым для атак.

Nginx — один из наиболее часто используемых веб-серверов в Интернете, поскольку он модульный, отзывчивый под нагрузкой и может масштабироваться на минимальном железе. Компания Detectify регулярно сканирует Nginx на предмет неправильных настроек и уязвимостей, из-за которых могут пострадать пользователи. Найденные уязвимости потом внедряются в качестве теста безопасности в сканер веб-приложений.

Мы проанализировали почти 50 000 уникальных файлов конфигурации Nginx, загруженных с GitHub с помощью Google BigQuery. С помощью собранных данных нам удалось выяснить, какие ошибки в конфигурациях встречаются чаще всего.

-

Вакансии

-

Разработчик Python (Middle, Django / FastAPI)от 120 000 до 180 000 Artel of Business Automation Можно удаленно

-

React Native разработчикот 80 000 до 180 000 2people IT Можно удаленно

-

Разработчикот 35 000 Novikova_agency Можно удаленно

-

Frontend / Vuejs Developerот 110 000 до 200 000 HttpLab Ростов-на-Дону Можно удаленно

-

ETL инженерот 130 000 до 180 000 deeplay Новосибирск Можно удаленно

-

-

12 марта 2021 в 19:46

12 марта 2021 в 19:46

Запуск Django сайта на nginx + Gunicorn + SSL

Читать далее

Читать далееДля написания этой статьи ушло очень много сил и времени. Я натыкался на множество инструкций, как на английском, так и на русском языках, но как я понял, - они все были клонами оригинальной статьи на Digital Ocean. Спросите вы, почему я так считаю, а все потому, что все ошибки и неточности передаются с одного ресурса на другой без всяких изменений.

-

18 февраля 2021 в 10:51

18 февраля 2021 в 10:51

Как мы сэкономили 2000 USD на трафике из Amazon S3 с помощью nginx-кэша

Читать далее

Читать далееЭта небольшая история — живое свидетельство того, как самые простые решения (иногда) могут оказаться очень эффективными. В одном из проектов руководство взяло курс на оптимизацию бюджета на инфраструктуру. В результате анализа всех статей расходов стало очевидным, что заметно выдаются счета за сетевой трафик из Amazon S3-бакета, где хранится публичная статика веб-приложения. Так появилась задача найти и реализовать максимально недорогой и решающий бизнес-задачу способ.

-

15 февраля 2021 в 16:52

15 февраля 2021 в 16:52

Уточняем детали проекта методами практической психологии

Читать далее

Читать далееПривет, Хабр! Меня зовут Владимир. Я разработчик в Максилекте. Помимо технического образования у меня есть бэкграунд в практической психологии. В этой статье я разберу модель уточнения, которая может быть полезна для дополнения информации о проекте как при обсуждении внутри команды, так и в разговорах с бизнесом. Модель содержит вопросы, которые стоит задавать, чтобы быстрее получить нужные данные.

Текст написан по материалам внутреннего тренинга, который я проводил в нашей компании в начале февраля.

-

Курсы

-

Основы вёрстки сайтов

24 мая 2021 5 недель 20 000 Loftschool

Основы вёрстки сайтов

24 мая 2021 5 недель 20 000 Loftschool -

SEO-специалист

24 мая 2021 4 месяца 58 435 Нетология

SEO-специалист

24 мая 2021 4 месяца 58 435 Нетология -

Профессия iOS-разработчик

24 мая 2021 12 месяцев 90 000 SkillFactory

Профессия iOS-разработчик

24 мая 2021 12 месяцев 90 000 SkillFactory -

Android-разработка. Продвинутый уровень

24 мая 2021 6 недель 30 000 Loftschool

Android-разработка. Продвинутый уровень

24 мая 2021 6 недель 30 000 Loftschool -

Веб-разработчик с нуля

24 мая 2021 13 месяцев 109 900 Нетология

Веб-разработчик с нуля

24 мая 2021 13 месяцев 109 900 Нетология

-

-

13 февраля 2021 в 13:43

13 февраля 2021 в 13:43

Телеграм-бот для автоматизации обменника криптовалюты

Хотите узнать больше?

Хотите узнать больше?В этой статье я буду в общих чертах рассказывать про то, в каком направлении нужно двигаться, чтобы сделать полуавтоматический обменник криптовалюты с возможностью управлять сделками с любого устройства в любой точке планеты 24/7. Вы не найдете здесь полной реалиализации, т.к. этот материал предназначен скорее для получения базового набора знаний, необходимых для запуска такого стартапа.

-

8 февраля 2021 в 08:49

8 февраля 2021 в 08:49

Солидные фронтенды: конфигурация

- Tutorial

Читать далееПравильная работа с параметрами фронтенд-приложения помогает создавать надежные и удобные в эксплуатации системы. Достаточно отделить конфигурацию от приложения и перенести ее в среду выполнения, чтобы радикально улучшить комфорт членов команды и снизить количество потенциальных ошибок. Разбираемся как это сделать.

-

28 января 2021 в 15:18

28 января 2021 в 15:18

Установка Redmine за 15 минут (RVM + RoR + Unicorn + Nginx)

Читать далее

Читать далееВ общем задача звучала так: установить Redmine на сервер, где веб-сервер на nginx.

Так как Redmine написан на RoR, то необходимо иметь RoR среду, но проблема в том, что разные RoR приложения могут требовать разные версии окружения. В моем случае необходимо было предусмотреть возможность установки RoR приложений с разным окружением, а значит нужен менеджер версий, который будет разворачивать нужную среду в нужном месте.

-

Заказы

-

Нужна помощь в доработке календаря на React Native3 000 за проект 0 откликов 4 просмотра

-

Сайт на вордпрессе с подключением оплаты и механизмом загрузки имеджей20 000 за проект 1 отклик 34 просмотра

-

Ruby on Rails проект от 3 до 6 месяцев1 200 за час 0 откликов 5 просмотров

-

Телеграмм бот для поиска вакансий8 000 за проект 5 откликов 25 просмотров

-

Реализовать алгоритм помехоустойчивого кодирования на ПЛИС10 000 за проект 0 откликов 5 просмотров

-

-

15 января 2021 в 10:00

15 января 2021 в 10:00

Запускаем свой RTMP сервер для стриминга

- Tutorial

Читать дальше →

Иногда YouTube или Twitch не подходят как стриминговая платформа — скажем, если вы пилите портал с вебинарами или контентом 18+, нарушаете авторские права или хотите максимально отгородить свою трансляцию от остального интернета. У них есть много альтернатив как в виде сервисов (те же минусы, недостаток контроля и непредсказуемая политика), так и в виде self-hosted решений. Проблема опенсорсных стриминговых проектов в том, что все они начинаются с крохотной связки из пары технологий, а затем отчаянно пытаются вырасти в сервис, добавляя сложные веб-интерфейсы, чаты, библиотеки стримов и в конечном счёте отдаляясь от исходной цели: дать миру инструмент, который по понятному мануалу позволит запустить свой сервер трансляций. Что с ним будет дальше, в какие системы будет встроена эта картинка — это только ваше личное дело, а самописный аналог твича с лагающими и отваливающимися сервисами и периодически валящимся билдом не нужен никому, кроме его разработчиков. Поэтому в этой статье мы разберём минимальную цепочку действий для запуска своего RTMP-сервера с плеером. -

15 декабря 2020 в 02:27

15 декабря 2020 в 02:27

Видео вещание с OvenMediaEngine, до свидания nginx rtmp module

- Tutorial

Читать дальше →

Когда Роман Арутюнян (rarutyunyan) выпустил модуль nginx-rtmp-module, это сильно перевернуло взгляд на доступность организации видеовещания. До этого, это казалось каким-то дорогим и сложным делом.

31 декабря Adobe официально хоронит флешплеер и убирает ссылки на скачивание с сайта. Это, конечно, не может не радовать. Эти засранцы то и дело подсовывали включенные по умолчанию галочки, так что даже продвинутому пользователю прилетал вместе с флешплеером еще и какой-то антивирус в лучшем случае. То, что это чудовище бесконечно просило обновлений ручками через браузер, знают все. Ходил даже анекдот, предлагающий создателям флешплеера законодательно ограничить паспорта сроком на 1 неделю с возможностью бесконечной перевыдачи.

-

26 октября 2020 в 11:00

26 октября 2020 в 11:00

Как сделать nginx безопасным

- Блог компании VDSina.ru,

- Open source,

- Системное администрирование,

- Nginx,

- Серверное администрирование

- Tutorial

Читать дальше →

TL;DR: абсолютно устойчивых систем не существует, поэтому ответ — никак. Но можно значительно упростить себе жизнь с помощью Docker-контейнера bunkerized-nginx. О том, чем он отличается от стандартного образа nginx и что интересного умеет, поговорим под катом.

-

25 октября 2020 в 10:14

25 октября 2020 в 10:14

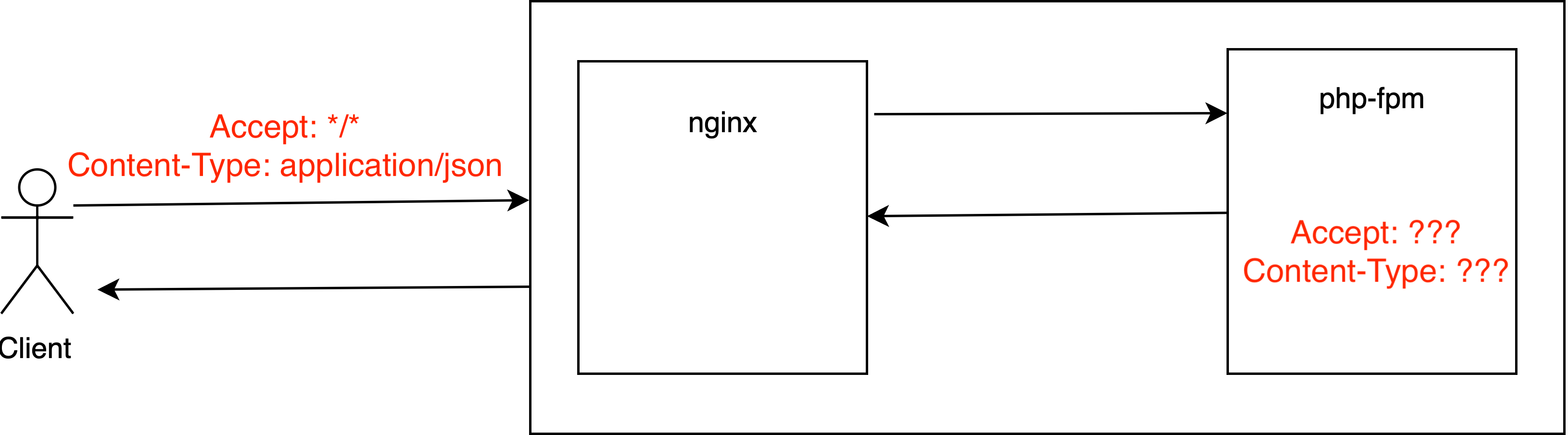

Откуда берется заголовок Content-Type: nginx + php-fpm

Rocket science не будет. Если вы используете php-fpm, то скорее всего в связке с nginx. Простой вопрос: как в PHP получить значения HTTP заголовков запроса клиента?Читать дальше →

- Например, стандартные Accept, Host или Referer?

- Знаете? Здорово! А как получить значение Content-Type, Content-Length?

- Ничем вас не удивить, а как получить значение произвольного заголовка, например X-Forwarded-For?